Der mit Abstand größte Teil der heute erzeugten Daten sind unstrukturierte Daten wie z.B. Fotos, Audiodaten, Videos oder Texte. Der Anteil der unstrukturierten Daten an der global gespeicherten Datenmenge wird auf ca. 80 % beziffert. Die Nutzung dieser Daten für analytische Erkenntnisse und Entscheidungen sowie die Automatisierung von Geschäftsprozessen stellt sich für die meisten Unternehmen noch als Herausforderung dar. Ein Grund dafür ist, dass unstrukturierte Daten im Gegensatz zu vorwiegend tabellarisch strukturierten Daten nicht ohne intelligentere Ansätze und Technologien zur (Vor-)Verarbeitung genutzt werden können. Dazu kommen die wesentlich größen Datenmengen und eine höhere Fehleranfälligkeit.

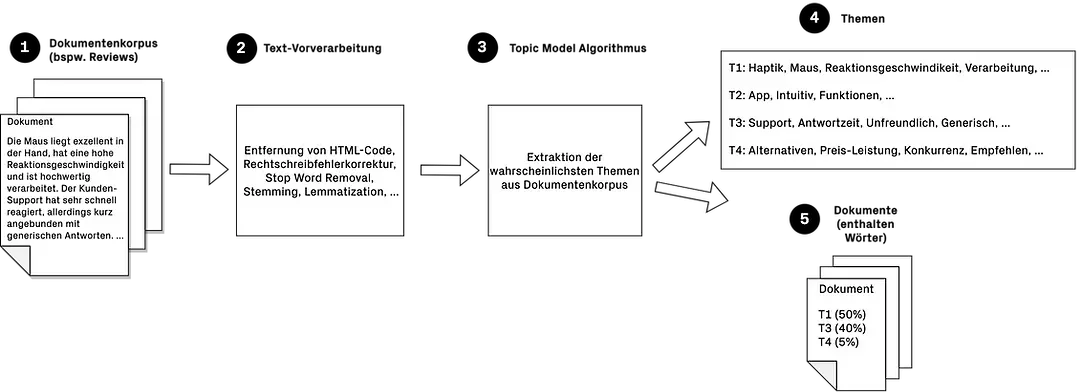

Allerdings lassen sich Textdaten heute mit modernen Verfahren wie dem Topic Modeling sehr gut in eine strukturierte und damit nutzbringende Form für Anwendungsfälle in den Bereichen Analytics und Automation bringen. Topic-Modeling ist eine Methode des maschinellen Lernens, mittels derer sich aus einem Dokumentenkorpus eine Reihe an Themen extrahieren lassen. Diese Themen bestehen wiederum aus Wörtern, die Gruppen oder Cluster von Dokumenten innerhalb des Dokumentenkorpus repräsentieren. Die extrahierten Themen können dann eigens definierten Kategorien zugewiesen werden, die den Dokumenten mit bestimmten Wahrscheinlichkeiten zugeordnet werden können.

Abb. 1: Ablauf der Dokumentenverarbeitung mit Topic Modeling

Topic-Modeling wird dem Bereich des sog. „Natural Language Processing“ zugeordnet, zu Deutsch „natürliche Sprachverarbeitung“, die insbesondere dann zum Einsatz kommt, wenn es bspw. darum geht, täglich hunderte oder gar tausende von Kundeninteraktionen effizient zu verarbeiten. Eine manuelle Verarbeitung bzw. Analyse von Kundeninteraktionen, Beiträgen in sozialen Medien, Umfragen etc. ist heutzutage größtenteils aufgrund der großen Datenmenge manuell nicht mehr möglich, ohne dabei enorme personelle Kostenaufwände zu erzeugen. Hinzu kommt das Risiko der hohen Fehleranfälligkeit bei manuellen Prozessen sowie die Zufriedenheit der Mitarbeiter, die unter den hochgradig repetitiven und monotonen Prozessen stark leidet. Durch den Einsatz maschineller Lernmethoden, wie dem Topic-Modeling, können die zuvor genannten Probleme durch die teilweise Automatisierung der Analyse- und Verarbeitungsprozesse effektiv angegangen werden.

In diesem Beitrag geben wir einen Einblick in die Methode des Topic-Modeling und diskutieren in diesem Zusammenhang beispielhafte Anwendungsfälle. Beim Topic-Modeling handelt es sich um eine nicht-überwachte maschinelle Lernmethodik, die kein Training des entsprechenden Algorithmus erfordert. Dementsprechend werden auch keine zuvor manuell kategorisierten Trainingsdaten benötigt. Die Analyse der Daten kann stattdessen sofort beginnen.

In Abgrenzung dazu handelt es sich bei der sog. Themenklassifizierung um eine überwachte maschinelle Lernmethodik, die ein vorheriges Annotieren einer Trainingsdatenmasse sowie ein Training des Algorithmus auf diesen Daten erfordert. Die Methode ist somit wesentlich aufwändiger, erreicht allerdings, wie es bei Methoden des überwachten maschinellen Lernens üblich ist, eine höhere Genauigkeit bei der automatischen Kategorisierung der Daten. Wir werden diese Methode in einem künftigen Blog-Beitrag näher erläutern.

Topic Models eignen sich insbesondere dann, wenn die Themenkategorien zu den Dokumenten unbekannt sind.

Topic-Modeling kann also verwendet werden, wenn kein Datensatz mit entsprechenden Labels vorhanden ist, um einen Klassifizierungsalgorithmus zu trainieren. Andererseits lassen sich Topic-Modeling und die damit einhergehenden Analysen auch als eine Art Vorstufe betrachten, in der aufschlussreiche Erkenntnisse über Dokumente gewonnen und (semi-) automatisiert Labels für einen großen Datensatz ermittelt werden. Diese Erkenntnisse und Labels können in einer anschließenden Phase genutzt werden, um präzisere Klassifizierungsalgorithmen zu erstellen.

Anwendungsfälle für Topic Modeling

Im Bereich der Kundenbetreuung kann die Kategorisierung sowie das Routing von Kundenanfragen an Algorithmen delegiert werden, die eine auf vorläufiger Einschätzung basierende Weiterleitung an das zuständige Team vornehmen. Somit werden beispielsweise Anfragen, die mit "Abrechnungsproblemen" oder "Rückerstattungen" gekennzeichnet sind oder Ausdrücke wie "Kreditkartentransaktion", "Abonnementfehler" usw. enthalten, an die Buchhaltungsabteilung weitergeleitet. Anfragen, die mit "Bug Issues" und "Software" gekennzeichnet sind oder Ausdrücke wie "App funktioniert nicht" enthalten, würden an das Entwicklungsteam geschickt werden. Die Mitarbeiter können sich somit auf weitaus wichtigere Aufgaben konzentrieren, bspw. Die Betreuung von Kunden, oder die Optimierung von Prozessen, in denen auf Basis der Topic-Modeling-Analysen Ineffizienzen oder Defizite erkannt wurden.

Ein besonders gut geeignetes Anwendungsszenario ist das automatisierte Routing von Kundenanliegen im Customer Support.

Kunden-Support-Tickets, die nicht einfach zu kategorisieren sind, können auf häufig auftretende Muster hin untersucht werden. Dadurch können nicht offensichtliche Probleme im Produkt oder der Dienstleistung erkannt und letztere verbessert werden.

Automatisches Erkennen der Dringlichkeit eines Support-Tickets und entsprechende Prioritätensetzung. Zum Beispiel, wenn ein Ticket als "Bug Issue" oder "Dringlich" gekennzeichnet ist oder eine Algorithmus Ausdrücke wie "schnellstmöglich", "sofortige Aufmerksam" usw. erkennt. Ein solcher Ansatz kann Unternehmen helfen, eine potenzielle PR-Krise zu vermeiden und sogar das Beste aus einer schlechten Situation zu machen.

Tritt ein Kunde in den direkten Kontakt mit dem Support-Team, kommt es nach Einverständnis des Kunden häufig zur Aufzeichnung der Interaktion. Aus solchen Gesprächen können durch Analysen ebenfalls tiefgreifende Erkenntnisse erlangt werden, um das Kundenerlebnis maßgeblich zu verbessern

Kunden-Feedback, d.h. Bewertungen, Beiträge in sozialen Medien, E-Mails, Chat oder Umfragen können durch das hier beschriebene Verfahren effektiv verarbeitet und effizient beantwortet werden. Darüber hinaus können fundierte Entscheidungen zum Umgang mit Kunden oder zu Verbesserung des eigenen Produkts bzw. der Dienstleistung getroffen werden. Bspw. kann massenhafte Auswertung von Freitextantworten aus NPS-Umfragen durch die automatisierte Analyse in Ergebnisse wie „85% der Kunden würden das Produkt einem Freund weiterempfehlen“ führen.

Welche Methoden gibt es?

In den letzten Jahrzehnten wurden zahlreiche Methoden zur Themenmodellierung entwickelt. Die meisten Methoden beruhen auf der Tatsache, dass ein Dokument typischerweise ein bestimmtes Thema behandelt und Wörter enthält, die häufig zusammen auftreten. Eine E-Mail, in der Sie beispielsweise Ihren nächsten Urlaub planen, enthält wahrscheinlich häufiger die Wörter "Flug" und "Hotel" als E-Mails zu anderen Themen. Dank dieser statistischen Regelmäßigkeit können nicht unmittelbar sichtbare Themen aus einer Vielzahl an Dokumenten effizient extrahiert werden.

Die Anzahl der automatisch zu entdeckenden Themen muss in der Regel festgelegt werden, was schwierig sein kann und davon abhängt, wie die Ergebnisse verwendet werden sollen. Die Interpretation der entdeckten Themen kann ebenfalls schwierig sein; obwohl sie oft durch ihre wichtigsten Wörter zusammengefasst werden können, entsprechen sie nicht unbedingt den Themen, die man zu finden erwartet hat. Bei moderneren Methoden, wie der unten vorgestellten BERTopic-Methode ist dies nicht der Fall. Diese Methode ist in der Lage, die Anzahl der Themen auf Basis der Dokumentenstrukturen selbst zu bestimmen.

Im Folgenden möchten wir einige verschiedene Methoden zur Anwendung der Themenmodellierung sowie die notwendige Textvorverarbeitung beleuchten und dabei den Fokus eher auf die Intuition hinter den Methoden legen als auf die mathematischen Details.

Vorverarbeitung der Dokumente

Grundsätzlich sollten Dokumente zuallererst von all dem Inhalt bereinigt werden, der absehbar keinen informativen Mehrwert liefert oder gar die Ergebnisse einer Themenmodellierung stark verzerren könnte. Dies kann bspw. HTML-Code sein oder, im Falle von Email-Nachrichten, der Email-Kopf sowie die Email-Signatur, da in den meisten Fällen nur der eigentliche Inhalt die Informationen enthält, die für die Themenmodellierung von Relevanz sind.

Eine etwas aufwändigere Art der Vorverarbeitung ist das Ersetzen von bestimmten Wort-Entitäten. Bspw. können eine IBAN oder eine Adresse gezielt entfernt oder durch fixe Tokens ersetzt werden. Dazu können Methoden aus dem Bereich der sog. Named-Entity-Recognition (kurz: NER) zum Einsatz kommen.

Ein weiterer wichtiger Aspekt kann die Bereinigung von Rechtschreibfehlern in Dokumenten sein. Gerade bei der Themenmodellierung, bei der einzelne wichtige Schlagwörter hohe Relevanz besitzen, können Rechtschreibfehler die Themenfindung stark negativ beeinflussen. Um Rechtschreibfehler zu bereinigen, können verschiedene Spellchecking-Libraries verwendet werden. Dabei ist jedoch vorher zu prüfen, wie zuverlässig diese bezogen auf den eigenen Anwendungsfall funktionieren. Ebenso spielt die Geschwindigkeit eine große Rolle.

Nach einer initialen Bereinigung muss zunächst der Inhalt aller Dokumente in ein numerisches Format überführt werden, das als Eingabe für eine Themenmodellierungsmethode bzw. einen Algorithmus dient. Die Art der Umwandlung in ein numerisches Format hängt dabei von der gewählten Themenmodellierungsmethode ab und auch davon, welche Vereinfachungen bei der Sprachmodellierung akzeptabel sind und dennoch das gewünschte Ergebnis erzielen.

Beispielweise können häufige Stoppwörter (z. B. der, und, auf) und ebenso seltene Wörter, die nur in wenigen Dokumenten vorkommen und oft nicht nützlich sind, entfernt werden. Darüber hinaus kann ein sog. „Wordstamming“ zur Reduktion von Wörtern auf ihre Wortstämme durchführt werden, um nur letztere in die Analyse einzubeziehen (z. B. wird aus „Wohnwagen“ und „bewohnen“ das Wort „wohn“). Während „Wordstamming“ eine eher grobe Methode in der Vorverarbeitung von Texten darstellt und häufig zur Unschärfe in der Bedeutung von Sätzen führt, bezieht sich die sog. Lemmatisierung auf die korrekte Verwendung eines Vokabulars und die morphologische Analyse von Wörtern, wobei in der Regel nur flektierende Endungen entfernt werden und die Grund- oder Wörterbuchform eines Wortes, das so genannte Lemma, zurückgegeben wird. Bei der Vorverarbeitung ist jedoch zu beachten, dass solche Techniken nicht für jede Themenmodellierungsmethode geeignet sind. Auf die Ausnahmen kommen wir nachfolgend noch zu sprechen.

Ein numerisches Format, das häufig im Rahmen der Themenmodellierung zur Anwendung kommt, ist die so genannte Wort-Dokumenten-Matrix (engl.: Term-Document Matrix). Bei diesem Format wird die Wortfolge außer Acht gelassen und einfach die Anzahl der Vorkommen jedes Wortes in einem Dokument gezählt. Diese Vereinfachung (auch als Bag-of-Words-Modell bekannt) reduziert die Komplexität der Darstellung der Originaldokumente erheblich und kann in bestimmten Fällen dennoch gute Ergebnisse liefern.

Die Wort-Dokumenten-Matrix ist eine sog. dünnbesetzte Matrix, die hauptsächlich Nullen enthält, da in allen Dokumenten in der Regel nicht alle Wörter verwendet werden. Dabei repräsentieren die Dokumente die Spalten der Matrix. Jede Zeile steht für ein Wort, das in mindestens einem der Dokumente vorkommt. Die Einträge der Matrix entsprechen somit der Anzahl der Wörter (Zeilen) in den jeweiligen Dokumenten (Spalten) erscheinen.

Die hier beschriebenen Schritte stellen nur die einfachste Form der Dokumentenvorverarbeitung dar und es gibt viele Erweiterungen, die angewandt werden können. Z. B. kann ein Eintrag in der Wort-Dokumenten-Matrix um die inverse Dokumentenhäufigkeit erweitert werden (engl.: Term Frequency – Inverse Document Frequency), ein Schema, das zur Gewichtung von Wörtern dient.

Klassische Methoden zur Themenmodellierung

Im Folgenden erläutern wir drei klassischere Methoden zur Themenmodellierung und diskutieren anschließend eine neuere, auf modernen NLP-Techniken basierende Methode sowie deren Vorteile gegenüber den klassischeren Methoden.

Methode 1: Latent Semantic Analysis (LSA)

Die latente semantische Analyse ist eine Methode, die in den späten 1980er Jahren von Deerwester, Dumais und anderen entwickelt wurde. Sie nimmt als Input eine Wort-Dokumenten-Matrix und faktorisiert diese in drei neue Matrizen, deren Produkt ursprüngliche Matrix ergibt. Dies wird durch die Anwendung einer linearen Algebra-Methode namens Singulärwert-Zerlegung (SVD) erreicht, wobei die Faktorisierung als M = UΣV' dargestellt werden kann.

Jede faktorisierte Matrix gibt uns einen Einblick in potenzielle Themen, die in der ursprünglichen Term-Dokument-Matrix verborgen sind. Die Matrix U ordnet Wörter einem Themenraum zu, die Matrix V ordnet Dokumente demselben Themenraum zu und die Matrix Σ ist eine diagonale Matrix, die uns die "Stärke" eines jeden Themas angibt - wobei starke Themen mehr Varianz in den zugrunde liegenden Daten erfassen.

Methode 2: Probabilistic Latent Semantic Analysis (PLSA)

Die probabilistische latente semantische Analyse (PLSA) ist eine probabilistische Version der LSA und wurde 1999 von Hoffman entwickelt. PLSA und LSA versuchen zwar, ein ähnliches Problem im Zusammenhang mit der Modellierung von Themen in einem Korpus zu lösen, aber ihre Ansätze sind sehr unterschiedlich. PLSA ist ein probabilistisches, generatives Modell im Vergleich zu LSA, einem deterministischen Modell ist, welches lineare Algebra verwendet. Genau wie LSA arbeitet auch PLSA mit einer Wort-Dokumenten-Matrix.

Ein probabilistisches generatives Modell beschreibt einen Prozess, wie Daten durch eine Abfolge von probabilistischen Schritten entstanden sind - in hier betrachteten Fall von Dokumenten handelt es sich dabei um den Prozess, wie die Dokumente geschrieben oder generiert worden sein könnten. Anhand dieses Modells oder dieses Prozesses wird dann mittels statistischer Inferenz auf versteckte/unbeobachtete Variablen geschlossen, die in diesem Fall verschiedene Themen darstellen.

Methode 3: Latent Dirichlet Allocation (LDA)

Die Latent-Dirichlet-Allokation wurde 2003 von Blei, Ng und Jordan entwickelt und stellt eine Verallgemeinerung von PLSA dar. Einige Schwächen von PLSA werden durch LDA ausgebessert. Es handelt sich bei LDA ebenfalls um ein probabilistisches generatives Modell, ähnlich wie PLSA. Im Gegensatz zu PLSA ermöglicht LDA die Kodierung zusätzlicher Informationen durch die Verwendung von probabilistischen Verteilungen über Themen und Wörter. Wie die anderen vorgestellten Methoden arbeitet LDA mit einer Wort-Dokumenten-Matrix.

Die Verteilung, die LDA zur Modellierung von Themen und Wörtern verwendet, ist die Dirichlet-Verteilung, mittels derer die Unsicherheit bei der Stichprobenziehung aus einer festen Anzahl unterschiedlicher Kategorien modelliert werden kann. Die Dirichlet-Verteilung stellt eine gängige Priorverteilung in der Bayes'schen Statistik dar. Bei der Anwendung von LDA auf die Themenmodellierung wird in der Regel eine Dirichlet-Prior-Verteilung für Themen pro Dokument und eine weitere für Wörter pro Thema verwendet.

Der Vorteil dieses Ansatzes ist, dass das Modell in der Lage ist, die Annahme einzuschließen, dass ein Dokument tendenziell nur eine kleine Anzahl von Themen abdeckt; diese Eigenschaft einer geringen Anzahl an Themen hilft, eine Überanpassung (Overfitting) der Daten zu verhindern, insbesondere bei einem kleineren Dokumentenkorpus. Ein Dirichlet-Prior kann auch zu einer besseren Auflösung sprachlicher Wort-Mehrdeutigkeit (Disambiguierung) führen und bietet generell eine bessere Zuordnung von Themen zu Dokumenten. Wenn ein nicht informativer flacher (d.h. einheitlicher) Dirichlet-Prior verwendet wird, ist das LDA-Modell äquivalent zu PLSA.

BERTopic als wegweisender Ansatz für die Themenmodellierung

Probabilistische Modelle wie LDA erweisen sich generell als guter Ausgangspunkt zur Themenmodellierung, erfordern allerdings immer einen hohen Aufwand, um die Hyperparameter anzupassen und sinnvolle Themen zu gewinnen. Darüber hinaus sind solche Modelle zwar algorithmisch sehr anspruchsvoll, allerdings werden die besten Ergebnisse im NLP-Bereich heutzutage durch Transformer-basierte Modell wie BERT erzeugt. Transformer-Modelle sind zwar aufwändig zu trainieren, allerdings gibt es bereits eine Vielzahl frei verfügbarer vortrainierter Modelle in zahlreichen Sprachen die sehr genauer Repräsentationen von Wörtern und Sätzen enthalten und sich dadurch für ein breites Spektrum an NLP-Aufgaben nutzen lassen.

Bei BERTopic handelt es sich um eine solche modernere Methode zur Themenmodellierung, die Hugging Face-Transformers und c-TF-IDF (ein klassenbasiertes TF-IDF-Verfahren) nutzt, um dichte Wort-Cluster zu erstellen, die leicht interpretierbare Themen ermöglichen, während wichtige Wörter in den Themenbeschreibungen erhalten bleiben.

BERTopic umfasst drei Stufen:

Im ersten Schritt werden Dokumenteneinbettungen erzeugt, d.h. die Dokumente werden in numerische Vektoren in hochdimensionalen Räumen überführt. Die geschieht unter Verwendung von Sentence-Transformers. Diese Modelle sind für viele Sprachen vortrainiert und eignen sich hervorragend für die Erstellung von Dokumenten- oder Satzeinbettungen.

Im zweiten Schritt kommt es zum Clustering der Dokumente, die durch hochdimensionale Embeddings (Einbettungen) dargestellt werden. Normalerweise haben Clustering-Algorithmen Schwierigkeiten, Daten im hochdimensionalen Raum zu clustern. Bevor wir unsere Dokumente also clustern können, müssen wir zunächst die Dimensionalität der von uns generierten Einbettungen reduzieren.

Zu diesem Zweck wird der UMAP-Algorithmus verwendet, da es sowohl die lokale als auch die globale Struktur der Einbettungen gut erhält (bspw. im Gegensatz zum T-SNE Algorithmus, der nur die lokale Struktur erhält). Anschließend verwenden wir HDBSCAN, um die reduzierten Einbettungen zu clustern und der Algorithmus erlaubt, Ausreißer zu identifizieren.

Im dritten und letzten Schritt werden Themenrepräsentationen erzeugt. Was wir von den generierten Clustern wissen wollen, ist, was einen Cluster auf der Grundlage seines Inhalts von einem anderen unterscheidet. Um dieses Problem zu lösen, können wir TF-IDF so modifizieren, dass es interessante Wörter pro Cluster von Dokumenten statt pro einzelnem Dokument zulässt.

Wenn TF-IDF wie üblich auf eine Reihe von Dokumenten angewendet wird, vergleicht man die Bedeutung der Wörter zwischen den Dokumenten. Stattdessen kann man alle Dokumente in einer bestimmten Kategorie (z. B. einem Cluster) als ein einziges Dokument behandeln und dann TF-IDF anwenden. Das Ergebnis wären Gewichtungen für Wörter innerhalb eines Clusters. Je mehr wichtige Wörter in einem Cluster enthalten sind, desto repräsentativer ist es für ein bestimmtes Thema. Mit anderen Worten: Wenn die wichtigsten Wörter pro Cluster extrahiert werden, entstehen Repräsentationen von Themen. Dieses Modell wird klassenbasiertes TF-IDF genannt.

Jeder Cluster wird in ein einzelnes Dokument umgewandelt, anstatt in eine Menge von Dokumenten. Dann wird die Häufigkeit des Wortes x in der Klasse c extrahiert, wobei sich c auf den zuvor erstellten Cluster bezieht. Das Ergebnis ist die klassenbasierte tf-Darstellung.

Als nächstes wird der Logarithmus von eins plus die durchschnittliche Anzahl der Wörter pro Klasse A geteilt durch die Häufigkeit des Wortes x in allen Klassen errechnet. Anschließend erfolgt Addition von eins innerhalb des Logarithmus, um positive Werte zu erzwingen. Das Ergebnis ist die klassenbasierte IDF-Darstellung.

Wie bei der klassischen TF-IDF wird dann tf mit idf multipliziert, um den Wichtigkeitswert pro Wort in jeder Klasse zu erhalten.

Optional kann zuletzt die sog. „Maximale marginale Relevanzkohärenz“-Methode angewandt werden.

Nachdem die c-TF-IDF-Darstellungen erzeugt wurde, liegt eine Menge von Wörtern vor, die eine Sammlung von Dokumenten beschreibt. Technisch gesehen bedeutet dies nicht, dass diese Sammlung von Wörtern ein kohärentes Thema beschreibt. In der Praxis beschreiben viele der Wörter ein ähnliches Thema, aber bei einigen Wörter kommt es in gewisser Weise zu einem Overfitting bezogen auf die Dokumente. Dies kann beispielsweise bei einer Reihe von Dokumenten vorkommen, die von der gleichen Person geschrieben wurden und deren Unterschrift in der Themenbeschreibung steht.

Um die Kohärenz der Wörter zu verbessern, wurde die maximale marginale Relevanz verwendet, um die kohärentesten Wörter zu finden, ohne dass es zu viele Überschneidungen zwischen den Wörtern selbst gibt. Dies führt dazu, dass Wörter, die nicht zu einem Thema beitragen, entfernt werden.

Diese Technik kann auch verwendet werden, um die in der Themendarstellung generierten Wörter zu diversifizieren. Es kann vorkommen, dass viele Varianten desselben Wortes in der Themendarstellung auftauchen. Um die Anzahl der Synonyme zu reduzieren, können wir die Vielfalt der Wörter erhöhen und gleichzeitig die Ähnlichkeit zur Themendarstellung zu bewahren.

Vergleich und Abgrenzung zu klassischeren Methoden sowie Vorteile von BERTopic

Bei LDA handelt es sich um fortgeschrittene Standardmethode im Bereich des Topic Modeling, die auf probabilistischen Ansätzen basiert. Dabei werden Dokumente als eine Mischung von Themen betrachtet und dass einige Wörter mit einer höheren Wahrscheinlichkeit in bestimmten Themen vorkommen als in anderen. LDA liefert also einen Wahrscheinlichkeitsvektor für jedes Dokument, das zu einem bestimmten Thema gehört.

BERTopic basiert auf sog. „Word-“ und „Sentence-Embeddings“, die den Kontext der Dokumente in die Themenmodellierung mit einbezieht. Durch diese Eigenschaft können einerseits bessere Ergebnisse erzielt werden. Andererseits besitzen Embeddings jedoch eine hohe Anzahl an Dimensionen, was bei Clustering-Algorithmen zu Problemen führt.

Dementsprechend müssen die Embeddings zunächst einer Dimensionsreduktion unterzogen werden, bspw. mittels UMAP-Algorithmus. Insgesamt steigt damit die Gesamtsystemkomplexität im Vergleich zu klassischeren Methoden.

Um durch die Verwendung von kontextbasierten Dokumenten-Embeddings eine signifikante Verbesserung zu bewirken, kann bspw. BERT verwendet werden. Die hier vorgestellte entsprechende Implementierung ist BERTopic. Diese bringt eine Reihe von intuitiven Analyse- und Visualisierungsmöglichkeiten mit, die ein Fine-Tuning der Modellparameter sowie die Gewinnung aufschlussreicher Erkenntnisse zur Dokumentenstruktur erlaubt.

Fazit

Im Falle eines großen Dokumentenkorpus empfehlen wir die Umsetzung modernerer, Transformer-basierter Methoden zur Themen-Modellierung. Diese zeigen im Vergleich zu klassischeren Methoden in vielen Fällen bessere Ergebnisse und erfordern weniger Aufwand im Sinne des Hyperparameter-Tunings. Allerdings sollte beachtet werden, dass auch die Computing-Kosten höher sind, insbesondere dann, wenn für den eigenen Dokumentenkorpus Dokumenten-Embeddings erzeugt werden sollen. Dazu kommt der Black Box-Aspekt, der bei Deep Learning basierten Methoden (wie es bei Transformer-Modellen der Fall ist) immer zum Tragen kommt und der die Erreichung einer hundertprozentigen Modell-Transparenz immer erschwert. Die Verwendung klassischerer Methoden wie LDA kann nach wie vor sinnvoll sein. Für die Verwendung klassischerer Methoden existieren bereits bewährte Strategien und darüber hinaus eignen sich diese perfekt als Baseline-Modelle zum Vergleich mit moderneren Methoden, da die Performance letzterer immer nur im anhand von Referenzmodellen evaluiert werden kann.

Sind sie an intelligenteren Verfahren zur Verarbeitung von textbasierten Dokumenten interessiert? Wir beraten Sie gerne umfassend bei allen Fragestellungen in den Bereichen Themen-Modellierung und Dokumenten-Klassifizierung für diverse Anwendungsfälle der fortgeschrittenen Analyse und der intelligenten Prozessautomatisierung.

Literatur

- https://monkeylearn.com/blog/introduction-to-topic-modeling/

- https://blog.infocruncher.com/2017/11/30/topic-modelling-part-1-overview/

- https://maartengr.github.io/BERTopic/index.htmlhttps://www.kdnuggets.com/2020/11/topic-modeling-bert.html

- Marr, B. (2015): Big Data: Using SMART Big Data, Analytics and Metrics to Make Better Decisions and Improve Performance, London: Wiley