Die Automatisierung des technischen Supports hat sich in den letzten Jahren erheblich weiterentwickelt. Dabei spielen KI-Agenten eine zentrale Rolle. Eine spezielle Form davon sind Chat Agents, die als digitale Assistenten Kundenanfragen automatisiert bearbeiten. Besonders leistungsfähige Large Language Models (LLMs) wie GPT-4o ermöglichen es diesen Systemen, natürliche Sprache zu verstehen und kontextbezogene Antworten zu generieren.

Doch um einen effektiven Chat Agent zu entwickeln, reicht ein leistungsstarkes Sprachmodell allein nicht aus – entscheidend sind eine durchdachte Datenverarbeitung und Architektur, die den Zugriff auf unternehmensspezifische Informationen ermöglichen. In diesem Artikel werfen wir einen Blick auf die Entwicklung von LLMs, die Rolle des Frameworks LlamaIndex und die Architektur eines Chat Agents, der technisches Fachwissen effizient verarbeitet und bereitstellt.

Die Entwicklung von LLMs: Immer leistungsstärkere Sprachmodelle

Mit der Veröffentlichung von ChatGPT durch OpenAI wurde KI-basierte Sprachverarbeitung für viele Unternehmen zu einer greifbaren Technologie. Doch die Entwicklung ging rasant weiter:

- GPT-4o: OpenAIs multimodales Modell verarbeitet und generiert Text, Bilder sowie Audio. Es ist schneller und kosteneffizienter als sein Vorgänger GPT-4 und bietet erweiterte Fähigkeiten in der Sprachverarbeitung.

- o3-mini: Dieses kompakte Modell von OpenAI kombiniert hohe Rechenleistung mit niedrigen Kosten und bietet erweiterte Denkmodi, die je nach Anwendungsfall flexibel gewählt werden können. Es ist ideal für Szenarien, in denen schnelle und präzise Antworten erforderlich sind.

- Claude Sonnet 3.7: Das neueste Modell von Anthropic zeichnet sich durch eine hybride Denkweise aus, die zwischen schnellen Antworten und tiefergehenden Analysen wechselt. Besonders stark ist es in der Softwareentwicklung und bei kreativen Problemlösungen.

- QwQ-32B: Alibaba hat mit diesem 32-Milliarden-Parameter-Modell eine effiziente Lösung entwickelt, die trotz geringerer Größe mit deutlich größeren Modellen in Mathematik, Programmierung und technischer Analyse konkurrieren kann.

Diese Entwicklungen zeigen: KI wird immer leistungsfähiger, doch für den praktischen Einsatz benötigt sie eine optimierte Datenverarbeitung. Hier kommt LlamaIndex ins Spiel. Mit der Veröffentlichung von ChatGPT durch OpenAI wurde KI-basierte Sprachverarbeitung für viele Unternehmen zu einer greifbaren Technologie. Doch die Entwicklung ging rasant weiter:

LlamaIndex: Die Brücke zwischen Sprachmodellen und Unternehmensdaten

Moderne Sprachmodelle wie GPT-4 sind beeindruckend, jedoch können sie nicht direkt auf unternehmensspezifische Datenbanken, Dokumente oder Serviceberichte zugreifen. Das bedeutet, dass ihr Potenzial für technische Supportanwendungen nur dann ausgeschöpft werden kann, wenn sie mit strukturierten Unternehmensdaten verknüpft werden. LlamaIndex wurde genau dafür entwickelt: Es verbindet KI-Modelle mit den relevanten Datenquellen und stellt sicher, dass Antworten nicht nur intelligent, sondern auch präzise und anwendungsbezogen sind.

Wie funktioniert LlamaIndex?

- Datenindexierung: Technische Dokumente, Handbücher oder Serviceberichte werden in einer speziellen Datenbank, einer sogenannten Vektordatenbank, organisiert. Diese ermöglicht es, Inhalte effizient zu speichern und schnell wiederzufinden.

- Intelligente Abfragen: Wenn ein Nutzer eine Frage stellt, wird diese in eine mathematische Form umgewandelt (Vektoren). Das hilft dem System, die passendsten Inhalte aus den gespeicherten Dokumenten zu identifizieren – ähnlich wie eine Suchmaschine, nur viel präziser.

- Antwortgenerierung: Das Sprachmodell (z. B. GPT-4) nutzt die gefundenen Informationen, um eine fundierte und kontextbezogene Antwort zu formulieren. Das bedeutet: Die KI liefert nicht nur allgemeine Antworten, sondern genau die Informationen, die aus den unternehmensspezifischen Dokumenten stammen.

Durch den Einsatz von LlamaIndex kann ein Chat Agent gezielt auf firmenspezifische Informationen zugreifen und fundierte Antworten geben – ohne dass der Nutzer selbst in langen Dokumenten nachschlagen muss.

Architektur eines leistungsstarken Chat Agents

Ein intelligenter Chat Agent muss nicht nur Sprache verstehen, sondern auch effizient auf relevante Daten zugreifen und mit Nutzern interagieren. Dafür braucht er eine durchdachte Struktur, die aus verschiedenen zentralen Komponenten besteht. Diese Komponenten bilden gemeinsam die technische Architektur des Chat Agents und bestimmen, wie er funktioniert und mit anderen Systemen interagiert.

Die Kernkomponenten eines Chat Agents

- Benutzerschnittstelle: Einfache und intuitive Interaktion über Text- oder Spracheingabe.

- Natürliche Sprachverarbeitung (NLP): KI-Modelle wie GPT-4 verarbeiten Anfragen und generieren Antworten.

- Datenmanagement mit LlamaIndex: Effiziente Indexierung und Abfrage von technischen Dokumenten.

- Kontextanalyse: Berücksichtigung vergangener Interaktionen und Gerätehistorien.

- Integrationen: Anbindung an CRM-Systeme, Ticketing-Software und IoT-Sensorik.

- Lernmodul: Kontinuierliche Verbesserung durch Feedback und neue Daten.

Diese Architektur ermöglicht es Unternehmen, einen skalierbaren und leistungsstarken Chat Agent bereitzustellen, der den technischen Support effizient unterstützt.

Modularität und Anpassungsfähigkeit der Architektur eines Chat Agents

Die Architektur eines leistungsstarken Chat Agents basiert auf einem modularen Ansatz, der Flexibilität und Erweiterbarkeit gewährleistet. Jeder der oben genannten Kernkomponenten ist so gestaltet, dass sie unabhängig optimiert und weiterentwickelt werden kann.

- Skalierbarkeit: Jedes Modul kann unabhängig voneinander skaliert werden, um eine hohe Nutzerzahl oder erweiterte Funktionalitäten zu bewältigen.

- Einfache Wartung und Updates: Da die Architektur modular aufgebaut ist, können einzelne Komponenten aktualisiert oder ausgetauscht werden, ohne das gesamte System zu beeinträchtigen.

- Erweiterbarkeit: Neue Funktionen oder Integrationen können flexibel hinzugefügt werden, etwa durch die Anbindung zusätzlicher Datenquellen oder die Implementierung neuer Spracherkennungsmodelle.

- Optimierung durch A/B-Tests: Durch den modularen Aufbau lassen sich verschiedene Varianten einer Funktion parallel testen, um die bestmögliche Nutzererfahrung sicherzustellen.

Dieser modulare Ansatz sorgt dafür, dass der Chat Agent nicht nur aktuelle Anforderungen erfüllt, sondern auch für zukünftige Entwicklungen gerüstet ist. Er kann problemlos an neue Technologien und sich wandelnde Geschäftsanforderungen angepasst werden, was Unternehmen eine langfristige Investitionssicherheit bietet.

Fazit: Warum Chat Agents die Zukunft des technischen Supports sind

Die Kombination aus leistungsstarken LLMs wie GPT-4, einer effizienten Datenverarbeitung mit LlamaIndex und einer durchdachten Chat Agent-Architektur führt zu einer neuen Generation von KI-gestützten Supportsystemen.

Unternehmen profitieren von:

- Schnelleren Reaktionszeiten

- Besserer Informationsbereitstellung

- Reduzierten Supportkosten

- Höherer Kundenzufriedenheit

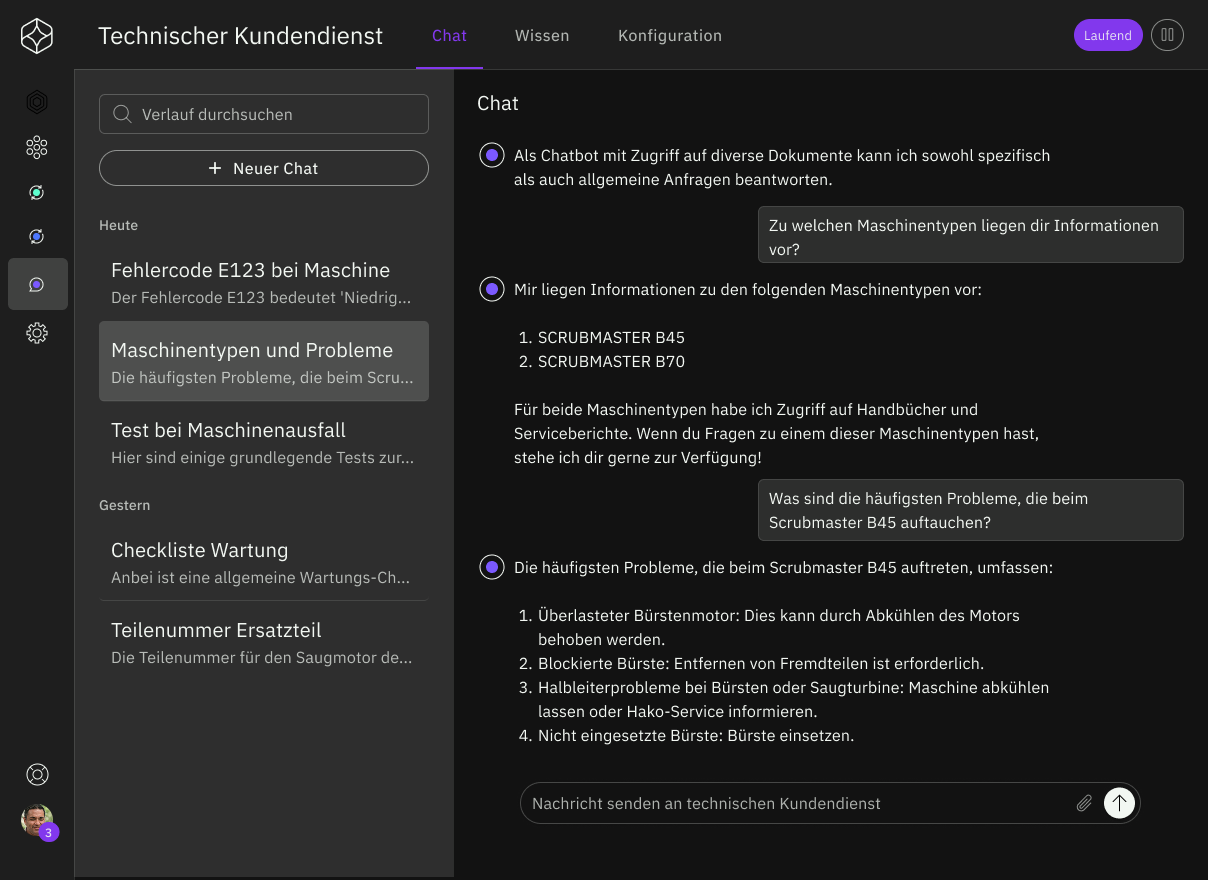

Ein Beispiel für eine erfolgreiche Implementierung ist unser Chat Agent für HAKO, der bereits signifikante Verbesserungen im technischen Support ermöglicht. Durch seine Fähigkeit, technische Dokumentationen, Serviceberichte und frühere Supportfälle effizient zu analysieren, reduziert er die Reaktionszeit drastisch und steigert die Problemlösungsrate erheblich. Dies führt zu einer spürbaren Entlastung der Support-Mitarbeiter, geringeren Ausfallzeiten der Maschinen und höherer Kundenzufriedenheit. Gleichzeitig optimiert der Chat Agent durch kontinuierliches Lernen die Qualität seiner Antworten und verbessert so langfristig den gesamten Kundenservice.

Abbildung 1: Benutzeroberfläche des Chat Agents

Für weiterführende Informationen zur Rolle von KI-Agenten und zur Auswahl des passenden LLMs empfehlen wir die folgenden Artikel:

- KI-Agenten: Viel diskutiert, oft unterschätzt. Weit mehr als Chatbots!

- KI-Agenten im Einsatz: Welches LLM erzielt die besten Ergebnisse?

Maßgeschneiderte KI-Agenten für Ihre nahtlose Prozessautomatisierung

KI-Agenten, wie Chat Agents und Auto Agents, ermöglichen es Unternehmen, komplexe, wissensintensive Aufgaben zu automatisieren, die bisher nur von Menschen erledigt wurden. Doch ihr Erfolg hängt von einer strategischen Umsetzung ab: Welche Prozesse lassen sich automatisieren? Wie lässt sich der größte Nutzen erzielen?

Genau hier setzt DataSpark an: Unsere AI Platform ermöglicht die schnelle und flexible Bereitstellung maßgeschneiderter KI-Agenten, die sich nahtlos in bestehende IT-Landschaften integrieren – egal ob in der Cloud oder On-Premises. Unternehmen profitieren von skalierbarer Automatisierung, intelligenter Datenverarbeitung und der direkten Anbindung an ERP-, CRM- oder andere Unternehmenssysteme.

Wir haben bereits zahlreiche Unternehmen erfolgreich dabei begleitet, KI-Agenten von der ersten Idee bis zum produktiven Einsatz zu integrieren. Lassen Sie uns gemeinsam herausfinden, welches Automatisierungspotenzial in Ihren Prozessen steckt!